人工智能大模型训练对算力基础设施的要求从单卡拓展到了集群层面,这对大规模卡间互联的兼容性、传输效率、时延等指标提出了更高的要求。近日,中国移动研究院网络与IT技术研究所主任研究员陈佳媛在公开演讲中盘点了大模型发展的最新趋势,万亿参数大模型对于计算集群和互联技术的最新要求,并提出全向智感互联(OISA)的设计方案,以突破大规模卡间互联的技术瓶颈。

AI大模型发展仍遵循尺度定律

当前,AI大模型的发展呈现三大技术趋势。从规模来看,大模型的技术发展总体上遵循尺度定律(ScalingLaw),参数规模从千亿扩展到万亿,业界已出现多个万亿参数模型,十万亿模型即将出现。随着参数量的增大,大模型处理问题的能力也随之增强。例如,GPT-4(1.8万亿参数量)在处理复杂任务方面的能力已经远超GPT-3.5(1750亿参数量)。

从模型泛化程度来看,模型结构在原有Transformer的基础上,引入了扩散模型、MoE(混合专家模型),使得模型的泛化能力增强、性能提升,大模型从支持自然语言的单一模态下的单一任务,逐渐发展为支持语音、文字、图像、视频等多种模态下的多种任务。

从架构来看,模型架构正在从资源密集的稠密结构向资源节约的稀疏结构转变,通过只激活部分神经元,展现出与稠密结构相媲美的性能。

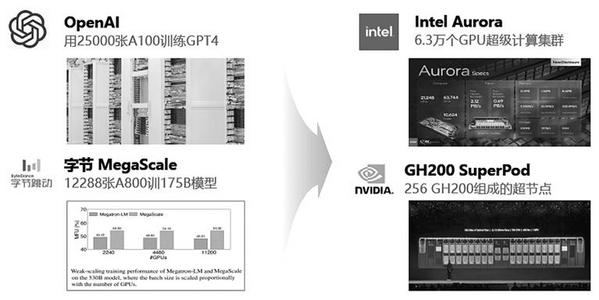

对于大模型企业而言,能否搭建起大算力的基础设施,成为能否实现大模型创新落地的关键。由此,国内外大型科技公司正在积极投建万卡集群智算中心。例如,OpenAI用25000张A100 GPU训练GPT-4。

万亿参数模型对卡间互联提出更高要求

大模型训练参数量的提高引发了业界对支撑该训练所需智算设备形态的思考:新一代智算设备需要具备更高密度的算存硬件、高性能无阻塞的网络连接以及更高并行度的训练策略和通信范式。

首先,万亿模型对卡间互联性能提出了更严苛的要求。

千亿模型的通信将服务器作为节点,单节点的通信要求集中在8卡以内。而在万亿参数量模型中,网络节点成为由百卡组建的“超节点”,同时MoE(混合专家模型)及并行策略被引入AlltoAll通信,其特征是单次通信数据量小,但通信频繁,对高带宽、低时延的要求更为迫切。陈佳媛认为,服务器的发展方向是TP(张量模型并行)效率提升,实现数据在所有的GPU之间充分计算。

其次,万亿模型需要包含交换芯片的互联拓扑。

当智算中心向百卡级别的全互联方向演进,传统的直连拓扑结构不再适用,迫切需要转向更高效、更先进的互联拓扑设计。在十亿参数或中等模型中,互联拓扑以桥接的形式实现,可以支持至多4卡的互联,单卡最大吞吐量为3个端口;在千亿参数模型中,国内主流方案是互联拓扑通过直连拓扑,以Cube Mesh或全互联方式实现,Cube Mesh支持通信需求从4卡拓展到8卡,单卡最大吞吐4~6个端口,全互联方式则可实现8卡全互联,单卡最大吞吐为7个端口,P2P带宽为几十个GB;而英伟达则通过8卡交换全互联方式实现,可将P2P带宽提升到百GB级别。

最后,万亿模型需要异构芯片之间构建大容量统一内存池。

模型规模的增长带来了对GPU显存容量需求的提高,单颗芯片往往难以满足对超大显存的需求。AI业务如搜索引擎、广告投放和推荐系统等,涉及大量数据处理、复杂算法计算和精密系统控制,这要求CPU、GPU等多个芯片能够高效协同作业。原有异构芯片连接基于PCIe实现,数据搬运速度慢,同时带宽受限,因此需要建立多异构芯片统一内存池,既在运行流程上实现多处理器内存一致性访问,又实现近TB/s级带宽能力。通过多异构芯片的互联实现统一内存池,能够提高显存性能、提升开发效率,促进CPU、GPU等有效协同。

突破GPU卡间互联技术瓶颈

当前,单芯片算力还跟不上生成式AI爆发性的需求。为满足需求,各半导体厂商纷纷推出性能更优的服务器芯片及更新的互联技术:行业标杆英伟达陆续推出超级芯片GH200和GB200;Intel Gaudi2采用8卡全互联拓扑,每个Guadi2芯片通过21个100Gb RoCEv2端口与其他7个芯片互联;AMD MI300X通过7个AMD Infinity Fabric链接组建8卡全互联拓扑。相比英伟达,尽管上述两款芯片具有较强的GPU互联能力,但由于缺少交换芯片,组建更大规模的纵向扩展集群面临挑战。

为解决这一问题,陈佳媛提出四个攻关方向:

第一,突破交换芯片性能瓶颈。提高卡间互联带宽,提升端口数量以满足集群算力纵向扩展升级需求;降低通信延迟,减少GPU通信跳数,优化数据传输路径。

第二,实现超百卡大规模物理连接。统筹单层、分层的网络拓扑结构,提高GPU间高速通信设计的点对点连接能力,实现P2P连接;优化GPU内存管理、计算和通信的重叠,实现软硬件协同。

第三,提升协议层面的互联效率。在算法层面,兼顾流量控制和拥塞控制条件下,实现低时延的传输性能;在协议层面,使主流协议满足传输需求;在数据包结构层面,保证数据包格式同时满足多种AI应用需求。

第四,要保持智算纵向扩展过程中的生态开放,其中包括保持遵循开放的行业标准,实现跨行业的广泛合作和建立开放的信息共享机制。

陈佳媛由此提出全向智感互联的设计,其内涵包括:全方位连接,使GPU可以与任何一张GPU实现对等通信;优化的报文格式,采用对GPU友好的报文格式以提高网络利用率,设计具备动态规模感知和简化机制的协议;实现高效物理传输,优化解串器、控制器等物理层组件,引入共封装光学技术降低功耗并提高信号完整性;灵活扩展,当需要增加更多GPU以提升计算能力时,新的GPU可以无缝融入现有互联网络中。

陈佳媛将这种设计架构称之为OISA——全向智感互联。其关键技术特征在于架构、物理、链路、事务等几个核心优化点。在架构层面,优化拓扑结构,引入高性能交换芯片和GPU交换IP来提升P2P带宽和研发效率。在物理层面,改进信号传输技术,减少噪声和干扰,提高信号质量和完整性,采用更先进的物理介质来提高数据传输效率,优化高速高能效的电互联接口解串器IP。在链路层面,优化错误检测和快速恢复技术,减少数据传输中的丢包和重传,采用多个物理链路提供更高的带宽和冗余路径。在事务层面,精简协议,提高数据处理速度,重定义报文头,增加GPU标识以提高传输效率。